COMPERATIVE

ASSESSMENT

Markov Modelling with Robotic Instruments

Comparative Assessment – Markov Modelling with Robotic Instruments is an innovative sound installation that explores the intersection of algorithmic composition, machine learning, and mechatronic performance. The project uses Markov models and neural networks to analyze and generate musical sequences in real-time. These compositions are brought to life by robotic instruments that interpret the data with mechanical precision, while visitors actively shape the soundscape through their input. This installation examines the evolving relationship between humans and machines in the creative process, highlighting the synergies and tensions between intuition and automation.

Comparative Assessment - Markov Modelling with Robotic Instruments ist eine innovative Klanginstallation, die den Schnittpunkt von algorithmischer Komposition, maschinellem Lernen und mechatronischer Performance erforscht. Das Projekt nutzt Markov-Modelle und neuronale Netze, um musikalische Sequenzen in Echtzeit zu analysieren und zu erzeugen. Diese Kompositionen werden von Roboterinstrumenten zum Leben erweckt, die die Daten mit mechanischer Präzision interpretieren, während die Besucher die Klanglandschaft durch ihre Eingaben aktiv gestalten. Die Installation untersucht die sich entwickelnde Beziehung zwischen Mensch und Maschine im kreativen Prozess und beleuchtet die Synergien und Spannungen zwischen Intuition und Automatisierung.

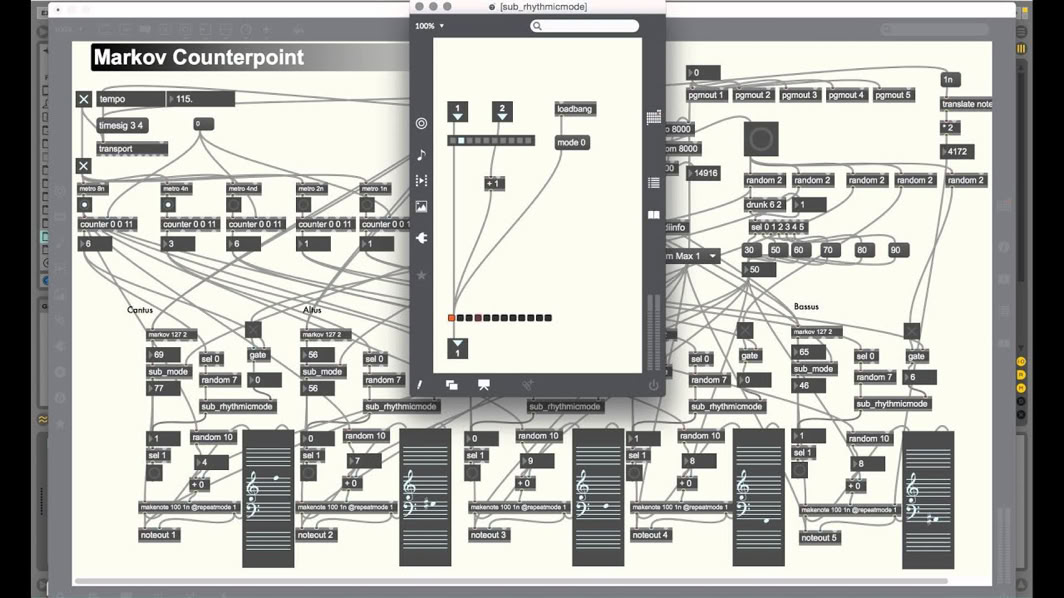

View example software application in MAX/MSP.

The project is rooted in the idea that music, with its mathematical structures and patterns, provides a natural foundation for algorithmic exploration. Markov models, as a fundamental tool in probability theory, have long been used to model sequential data, making them particularly suited for generating music. In this context, the installation uses Markov chains to predict the most probable next notes or chords based on prior input, creating compositions that are both structured and dynamic.

Visitors are invited to interact with the system by inputting melodies or chords through a MIDI device. These inputs are analyzed by a neural network and combined with pre-trained datasets to create new, evolving musical patterns. The generated sequences are then transmitted to mechatronic robotic instruments, which perform the compositions in real-time.

This interplay between human input and machine processing creates a unique sonic environment where the boundaries between composer, performer, and audience blur. The installation not only demonstrates the technical capabilities of modern algorithms but also poses deeper questions about creativity, authorship, and the role of machines in artistic expression.

/

Das Projekt basiert auf der Idee, dass Musik mit ihren mathematischen Strukturen und Mustern eine natürliche Grundlage für die algorithmische Erforschung bietet. Markov-Modelle, ein grundlegendes Instrument der Wahrscheinlichkeitstheorie, werden seit langem zur Modellierung sequentieller Daten verwendet und eignen sich daher besonders gut für die Erzeugung von Musik. In diesem Zusammenhang verwendet die Installation Markov-Ketten, um die wahrscheinlichsten nächsten Noten oder Akkorde auf der Grundlage vorheriger Eingaben vorherzusagen und so Kompositionen zu schaffen, die sowohl strukturiert als auch dynamisch sind.

Die Besucher sind eingeladen, mit dem System zu interagieren, indem sie Melodien oder Akkorde über ein MIDI-Gerät eingeben. Diese Eingaben werden von einem neuronalen Netz analysiert und mit zuvor trainierten Datensätzen kombiniert, um neue, sich entwickelnde musikalische Muster zu erzeugen. Die erzeugten Sequenzen werden dann an mechatronische Roboterinstrumente übertragen, die die Kompositionen in Echtzeit spielen.

Dieses Zusammenspiel zwischen menschlichem Input und maschineller Verarbeitung schafft eine einzigartige Klangumgebung, in der die Grenzen zwischen Komponist, Interpret und Publikum verschwimmen. Die Installation demonstriert nicht nur die technischen Möglichkeiten moderner Algorithmen, sondern wirft auch tiefere Fragen über Kreativität, Autorenschaft und die Rolle von Maschinen im künstlerischen Ausdruck auf.

Technical realisation / Technische Realisierung

The software basis of this project is the ml.star machine learning toolkit by Benjamin Day Smith, which was integrated into the Max/MSP environment by Cycling ‘74. This toolkit enables the use of advanced neural network models and machine learning algorithms. / Die Softwarebasis dieses Projekts ist das ml.star-Toolkit für maschinelles Lernen von Benjamin Day Smith, das von Cycling '74 in die Max/MSP-Umgebung integriert wurde. Dieses Toolkit ermöglicht die Verwendung von fortgeschrittenen neuronalen Netzmodellen und Algorithmen für maschinelles Lernen.

The process is structured as follows:/ Das Verfahren ist wie folgt aufgebaut:

Analysis and modulation/ Analyse und Modulation:

Pre-selected MIDI scores are analysed and new musical sequences are generated based on stochastic probabilities derived from Markov models. / Vorausgewählte MIDI-Partituren werden analysiert und neue musikalische Sequenzen werden auf der Grundlage von stochastischen Wahrscheinlichkeiten, die aus Markov-Modellen abgeleitet werden, generiert.

Interactive input/ Interaktive Eingabe:

Visitors or musicians can enter their own melodies or chords via a MIDI keyboard. These inputs are processed by a neural network, combined with existing data sets and further developed./ Über ein MIDI-Keyboard können Besucher oder Musiker ihre eigenen Melodien oder Akkorde eingeben. Diese Eingaben werden von einem neuronalen Netz verarbeitet, mit bestehenden Datensätzen kombiniert und weiterentwickelt.

Mechatronic instruments/ Mechatronische Instrumente:

The generated MIDI data is transmitted to a series of mechatronic robotic instruments that are connected to a central computing and control unit. These instruments interpret the data and create a unique soundscape./ Die erzeugten MIDI-Daten werden an eine Reihe von mechatronischen Roboterinstrumenten übertragen, die mit einer zentralen Rechen- und Steuereinheit verbunden sind. Diese Instrumente interpretieren die Daten und erzeugen eine einzigartige Klanglandschaft.

_____________________________________________________________________________________________________________________________________________________

_____________________________________________________________________________________________________________________________________________________

Since the invention of computers, there have been efforts to use them for composing music. This is hardly surprising when considering the mathematical patterns and relationships inherent in many musical styles – such as Bach’s Crab Canon, which ingeniously combines the same melody played both forwards and backwards. As early as 1739, the mathematician Leonhard Euler attempted to uncover the mathematical foundations of music in his work Tentamen novae theoriae musicae. In this treatise, Euler sought to explain the human perception of consonance and dissonance and developed a system of interval relationships based on prime numbers.

With advancements in machine learning and the increasing power of modern computers, new possibilities for algorithmic music generation have emerged. One widely used method is the application of Markov models. In probability theory, these models describe stochastic processes that simulate random changes in systems. The simplest Markov model, the Markov chain, uses a random variable whose state evolves over time. The Markov property asserts that the next state of a system depends only on its current state, not on its previous states. In other words, Markov models address questions such as: “What is the probability distribution of the next note, given a sequence like C, E, and G?”

To implement this approach, the project utilizes ml.star, a machine learning toolkit developed by Benjamin Day Smith. This toolkit is integrated into the Max/MSP virtual development environment by Cycling '74 and offers extensive interactive features. It enables the execution of advanced neural network models and machine learning algorithms in real time, allowing for the flexible manipulation of interactive parameters in complex performance scenarios.

The software first analyzes selected MIDI scores to derive stochastic probabilities. These probabilities can then be applied to connected instruments or used as input by musicians via a MIDI keyboard. This creates an interactive environment where both musicians and audience members can actively engage with the creative process, fostering a unique interplay between human and machine. /

Seit der Erfindung des Computers gibt es Bestrebungen, ihn zur Komposition von Musik einzusetzen. Das ist wenig überraschend, wenn man die mathematischen Muster und Beziehungen bedenkt, die in vielen Musikstilen vorkommen – etwa Bachs Krebskanon, der auf beeindruckende Weise dieselbe Melodie vorwärts und rückwärts kombiniert. Schon 1739 versuchte der Mathematiker Leonhard Euler in seiner Schrift Tentamen novae theoriae musicae, die mathematischen Grundlagen der Musik zu entschlüsseln. In diesem Werk suchte er eine Erklärung für das menschliche Empfinden von Konsonanz und Dissonanz und entwickelte ein Intervallverwandtschaftssystem, das auf der Basis von Primzahlen aufgebaut war.

Mit den Fortschritten im maschinellen Lernen und der Verfügbarkeit leistungsstarker Computer haben sich neue Möglichkeiten eröffnet, Musik algorithmisch zu erzeugen. Eine der häufig verwendeten Methoden ist die Anwendung von Markov-Modellen. In der Wahrscheinlichkeitstheorie beschreiben diese stochastische Prozesse, die zufällige Veränderungen in Systemen modellieren. Das einfachste Markov-Modell, die Markov-Kette, nutzt eine Zufallsvariable, deren Zustand sich über die Zeit hinweg verändert. Die Markov-Eigenschaft besagt, dass der nächste Zustand eines Systems nur vom aktuellen Zustand abhängt, nicht von den vorangegangenen. Anders ausgedrückt: Markov-Modelle beantworten Fragen wie: „Welche Note folgt mit welcher Wahrscheinlichkeit, wenn die aktuelle Sequenz C, E und G lautet?“

Zur Umsetzung der Software wird das von Benjamin Day Smith entwickelte Machine-Learning-Toolkit ml.star verwendet, das in die virtuelle Entwicklungsumgebung Max/MSP von Cycling '74 integriert ist. Dieses Toolkit bietet umfangreiche interaktive Erweiterungsmöglichkeiten und erlaubt die Ausführung fortgeschrittener neuronaler Netzwerkmodelle sowie maschineller Lernalgorithmen in Echtzeit. Dadurch lassen sich komplexe musikalische Strukturen in anspruchsvollen Aufführungssituationen erzeugen und interaktive Parameter flexibel steuern.

Das Programm analysiert zunächst ausgewählte MIDI-Partituren, um daraus stochastische Wahrscheinlichkeiten abzuleiten. Diese analysierten Daten können entweder direkt auf angebundene Instrumente übertragen oder von anwesenden Musikern über ein MIDI-Keyboard live eingespielt werden. So entsteht eine interaktive Umgebung, die sowohl Musiker als auch Gäste aktiv in den kreativen Prozess einbindet und ein einzigartiges Zusammenspiel zwischen Mensch und Maschine ermöglicht.